Die Künstliche Intelligenz (KI) ist zweifellos das vorherrschende Thema im Bereich der Softwareentwicklung und sie wird immer mehr zu einem integralen Bestandteil unseres täglichen Lebens. Auch aus der Automobilindustrie ist sie kaum mehr wegzudenken. Deshalb habe ich ChatGPT einmal gefragt, welche Trends bezüglich Automobilsoftware aktuell dominieren und das sind die Antworten:

- Daten und KI werden für die Automobilhersteller auch weiterhin eine wichtige Rolle spielen.

- Elektrofahrzeuge (EVs): Es wird erwartet, dass Elektrofahrzeuge im Jahr 2024 den Automobilmarkt stärker als je zuvor dominieren werden.

- Nachhaltigkeit in der Automobilproduktion: Mit dem Schwerpunkt auf umweltfreundlichen Praktiken macht die Automobilindustrie Fortschritte auf dem Weg in eine nachhaltigere Zukunft.

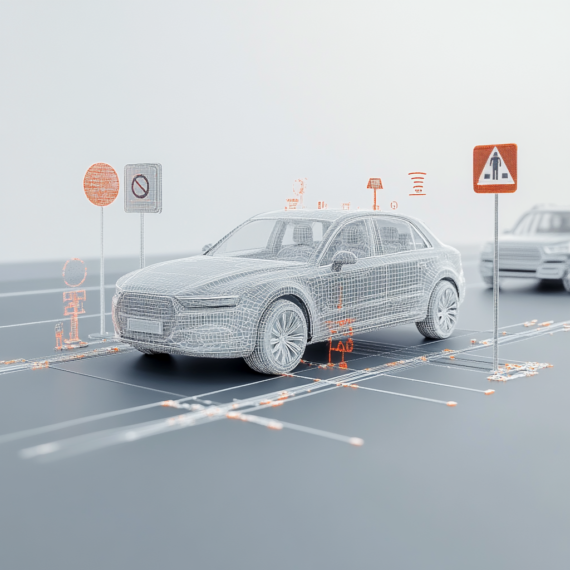

- Vernetzte Fahrzeuge: Die Integration von Technologie in Fahrzeugen geht über den Motor und die Sicherheitsfunktionen hinaus.

- Autonome Fahrzeuge, KI und ML: Die Mehrheit der Automobilentwickler (75 %) arbeitet intensiv an autonomen Fahrzeugen.

- Cybersecurity: Mit der zunehmenden Vernetzung von Fahrzeugen steigt auch das Risiko von Cyberangriffen.

Die Antworten zeigen, dass die Bedeutung von Data für die Zukunft des Autonomen Fahrens in unseren Fahrzeugen zunimmt. Um in das Thema tiefer einzusteigen, schauen wir uns erst einmal die Historie dessen an:

ADAS & Autonomes Fahren

Wenn wir über das Potenzial autonomer Fahrzeuge nachdenken, ist es wichtig, die Errungenschaften der Vergangenheit zu würdigen. Die Vorläufer des autonomen Fahrens werden unter dem Begriff Advanced Driver Assistance Systems (ADAS) zusammengefasst. Bei diesen Systemen handelt es sich um eine Reihe von Technologien, die in erster Linie darauf abzielen, die Fahrenden beim sicheren Führen eines Fahrzeugs zu unterstützen.

Geschichtliche Einordnung

Die Entwicklung der fortschrittlichen Fahrerassistenzsysteme (ADAS) beginnt 1948 mit der Erfindung des Tempomats durch den Ingenieur Ralph Teetor.

Mitte der 1950er Jahre verlagert sich nun der Schwerpunkt der Automobilindustrie auf die Entwicklung neuer Technologien, was zur Erfindung der Servolenkung und des automatischen Getriebesystems führt.

Die 1970er und 80er Jahre

Die Einführung von Hightech-Geräten und -Verfahren in der Automobilindustrie kennzeichnet die 1970er Jahre. In dieser Zeit werden die ersten Versionen der elektronischen Stabilitätskontrolle, des Toter-Winkel-Informationssystems, des adaptiven Tempomats und der Traktionskontrolle entwickelt.

In den 1980er Jahren entsteht ein neues Projekt: „VaMoRs“, kurz für „Vorfeldfahrzeug-Monitoring und -Rechner-System“. Es legt den Grundstein für die heutigen ADAS-Systeme. Der deutsche Wissenschaftler und Professor Ernst Dickmanns und sein Team beginnen mit der Entwicklung dieses zukunftsweisenden Projekts mit dem Ziel, ein Computer-Vision-System zu entwickeln, das in der Lage ist, Straßenmarkierungen und Fahrzeuge zu erkennen und zu verfolgen.

Ab den 2000ern

Nach der Jahrtausendwende sind die digitalen Kameratechnologien mittlerweile so fortgeschritten und zugänglich geworden, dass die Automobilindustrie sie für die bildverarbeitungsbasierte Erfassung der Umgebung einsetzen kann.

Heute konzentriert sich die Branche in erster Linie auf die Integration bestehender ADAS-Systeme mit künstlicher Intelligenz (KI) und ebnet damit den Weg für eine neue Ära intelligenter und autonomer Fahrzeuge.

Die Entwicklung der Initiative zum autonomen Fahren ist in den letzten vier Jahrzehnten tief verwurzelt. Die erste bedeutende Initiative entstand aus einer Zusammenarbeit zwischen der Carnegie Mellon University, der DARPA (US-Verteidigungsministerium), Mercedes Benz und der Universität München. In den 1980er Jahren gründen sie das halbautonome Projekt Navlab.

Die erste autonome Fahrt

Fast 15 Jahre später, im Jahr 1995, unternimmt der Prototyp Navlab 5 seine erste autonome Fahrt quer durch die USA. Er erreicht eine Durchschnittsgeschwindigkeit von 102,7 km/h (63,8 mph), wobei er 98,2 % der Strecke völlig autonom zurücklegt.

2019 verabschiedet die Europäische Kommission den Rechtsrahmen für den autonomen Verkehr: STRIA (Strategic Transport Research and Innovation Agenda) – ein Fahrplan für den vernetzten und autonomen Verkehr.

In einigen Regionen der USA sind heute bereits fahrerlose Taxidienste in Betrieb und die gesamte Automobilindustrie ist bestrebt, Innovationen zu fördern und den Grundstein für eine Zukunft zu legen, in der autonome Fahrzeuge mehr als 50 % der Transportmittel ausmachen.

Überblick über den Prozess des Maschinellen Lernens beim Autonomen Fahren

Der Prozess des Maschinellen Lernens, kurz ML, nutzt Daten und KI über die gesamte Verarbeitungskette des autonomen Fahrens. Der Prozess beginnt mit KI-Entwicklern, die mit Anforderungsspezialisten zusammenarbeiten, um eine umfassende Liste der technischen Anforderungen an die für den ML-Prozess erforderlichen Daten zu erstellen.

Es folgt die Datenerfassung und anschließend die Datenbeschriftung, bei der die zuvor erfassten Daten gemäß den vorher definierten, technischen Anforderungen beschriftet werden. Die beschrifteten Daten werden dann in Datensätzen gespeichert, die anschließend für das KI-Training verwendet werden, indem der Algorithmus damit gefüttert wird.

Umgebungswahrnehmung ermöglicht Autonomes Fahren

Die zum Trainieren und Validieren des Modells für Maschinelles Lernen (ML) benötigten beschrifteten Daten werden aus einer Mischung semantischer Informationen abgeleitet, die von verschiedenen Sensoren erfasst werden. Zu den wichtigsten Informationen, die als Input dienen, gehören:

- Metadaten, wie z.B. das Wetter, die Beschaffenheit der Straße oder das GPS

- Umgebungsdaten, wie z.B. Verkehrsschilder, Bordsteine, Zäune, Objekte auf der Straße, Gebäude

- Verkehrsteilnehmer: Ein bedeutender Fortschritt in diesem Bereich ist die Erkennung von Aktionen, die von diesen ausgeführt werden. Es ist von Vorteil, zu wissen, ob sich zum Beispiel ein Fußgänger auf der Straße befindet, der gerade durch ein Telefonat abgelenkt ist. Diese Detailgenauigkeit erhöht die Effektivität und Sicherheit des Machine-Learning-Modells in Autonomen Fahrszenarien erheblich.

- Fahrerstatistiken, die durch Sensortechnologie im Fahrzeuginneren, z. B. 2D/3D-Kameras, die auf den Fahrer gerichtet sind, und einen Radarsensor auf der Rückbank zur Überwachung der Insassen, erhoben werden können.

Datenkennzeichnung: Was, wie und warum?

Die am häufigsten verwendeten Daten für die Beschriftung stammen von verschiedenen Arten von Fahrzeugsensoren, wie den Kameras oder dem Lidar/Radar.

Die verwendeten Formate sind entweder Einzelbilder, Sequenzen oder Punktwolkendaten. Diese Datentypen werden unter Einsatz von proprietären oder Anbieter-Tools in einer 2D- oder 3D-Umgebung beschriftet.

Branchenaktuelle Entwicklungstrends und der Wunsch, einen Beitrag zur Zukunft von ADAS und autonomen Fahrzeugen zu leisten, unterstützt Forschung und Innovation in diesem Bereich.

Die Auswahl und Aufbereitung der Daten

Der Prozess der Datenkennzeichnung beginnt mit der Auswahl der Daten, auf die unmittelbar die Aufbereitung der ausgewählten Daten folgt.

Es gibt zwei Haupttypen von Daten, die potenziell verwendet werden können:

- Reale Daten, die von speziell ausgerüsteten Fahrzeugen aufgezeichnet und genau für diesen Zweck entwickelt wurden

- Synthetische Daten, die zu Testzwecken generiert wurden und die realen Daten so genau wie möglich nachahmen sollen

Die Datenextraktion erfolgt in der Regel bei Bedarf und oft über ein proprietäres Tool, das mehrere Filter- und Sortieroptionen bietet. Die Methode der Datenauswahl kann stark variieren und ist sehr spezifisch für die einzelnen technischen Anforderungen und den verwendeten Sensor. Dieser maßgeschneiderte Ansatz gewährleistet die effektivste Nutzung der Daten im Prozess des Maschinellen Lernens.

Arten der Datenauswahl

• Automatisch durch Verwendung des allgemeinen aktuellen Standes des ML-Modells

• Manuell: Bei dieser Auswahl stellt das Entwicklungsteam nach der Analyse der Leistung des ML-Modells Bereiche mit unzureichender Leistung fest und beschließt, sich auf die Verbesserung eines dieser Bereiche zu konzentrieren. Das Team extrahiert dafür bestimmte Daten aus der vorhandenen Datenbank und leitet sie zur Kennzeichnung weiter. Diese speziell beschrifteten Daten werden dann wieder in das ML-Modell eingefügt und seine Leistung wird neu bewertet. Dadurch kann das ML-Modell verfeinert und optimiert werden.

Konvertierung und Nachbearbeitung der Daten

Je nach Art der Daten können auf dieser Ebene mehrere Vorgänge stattfinden. Dazu gehören oft:

• Die Konvertierung von Bildern in Sequenzen (für sequenzbasierte Beschriftungsprojekte)

• Die Vorbereitung von Referenzdaten für die 3D-Beschriftung (häufig benötigen die von 3D-Sensoren erzeugten Punktwolkenbilder unterstützende visuelle 2D-Bilder für ein besseres Verständnis der Situation)

• Pre-Labels (KI-generierte Erkennung von relevanten Objekten, Umgebungen oder Verkehrsteilnehmern mit dem Hauptziel, den manuellen Aufwand der Datenbeschriftung zu reduzieren)

• Die Anonymisierung (dabei müssen alle menschlichen Gesichter und Nummernschilder anonymisiert werden, um die Privatsphäre zu schützen)

Case Study: Die Erkennung von Verkehrsschildern

Die Erkennung von Verkehrszeichen ist eine äußerst komplexe Komponente der Datenkennzeichnung für das autonome Fahren. Die Kennzeichnung von Daten für eine solche Komponente ist in der Regel ein manueller Prozess. Unternehmen ziehen es oft vor, dafür proprietäre Tools zu verwenden, die leicht je nach Regeln und Beschränkungen des Landes und der Region angepasst werden können.

Advanced List Formate

Die Beschriftung von Verkehrsschildern wird in der Regel von hochqualifizierten Fachleuten durchgeführt, die über ein tiefes Verständnis der komplexen technischen Anforderungen verfügen. Das Endprodukt ihrer Arbeit ist eine Sammlung von Dateien in einem der Advanced List Formate (ALF). Diese Dateitypen werden in erster Linie zur Speicherung strukturierter Daten verwendet, die später leicht manipuliert und als Eingabe für verschiedene Teile des ML-Algorithmus formatiert werden können.

Der für diese Art der Datenbeschriftung am besten geeignete Sensortyp ist der „Frontkamera“-Sensor, der 2D-Bilddaten in Form von Einzelbildern ausgibt, die anschließend zu Sequenzen zusammengefügt werden können. Eine große Herausforderung bei der Verwendung dieser Art von Daten für den ML-Algorithmus besteht in der Genauigkeit der Position jedes beschrifteten Objekts (Verkehrsschild) aufgrund der perspektivischen Ansicht, die der „Frontkamera“-Sensor erzeugt.

Das Machine Learning (ML) Modell für die Erkennung von Verkehrsschildern

Dieses Modell besteht in der Regel aus zwei Hauptteilen:

• Dem Training des ML-Modells: Hier sind die markierten Daten der Schlüsselfaktor, um sicherzustellen, dass das Modell gemäß den vorher festgelegten Parametern funktioniert.

• Der Validierung des ML-Modells: Hier werden verschiedene Datensätze verwendet, um die Leistungsparameter des Modells zu überprüfen. Der Zyklus der Eingabe neuer beschrifteter Datensätze in das Modell und der Beobachtung und Überwachung der Verbesserungen wird in der Regel wiederholt, bis die Leistung des Modells die vereinbarten Schwellenwerte erreicht hat.

Die Verwendung von zwei unterschiedlichen ML-Modellen

Bei der Erkennung von Verkehrsschildern ist es von Vorteil, zwei verschiedene ML-Modelle parallel zu verwenden – eines, das sich auf die Erkennung konzentriert, und ein anderes, das auf die Klassifizierung ausgerichtet ist.

Die Erkennung ist jedoch nur ein Aspekt dessen, was dieses komplexe Modell lernen kann. Es bezieht auch alle anderen Umweltkomponenten und Verkehrsteilnehmer mit ein. Es könnte dann in einer Umgebung eingesetzt werden, wo es die Position und die Bounding Box der vorhandenen Verkehrszeichen mit einer Genauigkeit von einigen Dutzend Pixeln erkennt und weitergibt. Speziell für die Erkennung von Verkehrsschildern könnte ein Klassifikatormodell verwendet werden, das die Arten von Verkehrsschildern in der Umgebung des Ego-Fahrzeugs identifiziert. Dieses Modell könnte anhand von Bildausschnitten mit bestimmten Verkehrsschildern trainiert werden.

Einige Beispiele für die Eigenschaften der einzelnen Verkehrszeichen, die dieses Modell erkennen muss, sind:

• Die Art des Verkehrszeichens (definiert durch die Gesetzgebung des jeweiligen Landes) und die Aktionskategorie, zu der es gehört: Beschränkung, Warnung, Gefahr, Richtungsweiser, …

• Der Text und die Werte innerhalb des Schildes (z. B. der Wert eines Schildes für eine Geschwindigkeitsbegrenzung)

• Die Relevanz für das Ego-Fahrzeug (ob das Schild direkt für das Ego-Fahrzeug oder für andere Verkehrsteilnehmer gilt)

• Mögliche Mängel (Schäden am Schild, verblasste Farbe, Aufkleber oder Graffiti)

Die endgültigen Ergebnisse wären eine Kombination aus dem, was das komplexe Erkennungsmodell ausgibt, und dem, was das Klassifikatormodell macht, stabilisiert zwischen mehreren Frames. Dies sollte in einer stabilisierten Umgebung getestet werden, um später in Verbraucherfahrzeugen eingesetzt werden zu können.

Wie könnte die Zukunft mit autonomen Fahrzeugen unser tägliches Leben möglicherweise verändern?

Derzeit sind wir dabei, den potenziellen autonomen Fahrzeugen beizubringen, wie sie sich an unsere Infrastruktur und Verkehrsregeln halten sollen. Wurde aber die Möglichkeit in Betracht gezogen, dass wir unsere derzeitigen Regeln anpassen müssen?

Die Tatsache, dass wir uns seit Jahrzehnten an dieselben Verkehrsregeln halten, deutet darauf hin, dass Veränderungen nicht leicht zu akzeptieren sind und die alten Regeln ursprünglich nicht mit einer solchen Zukunftsvision im Hinterkopf konzipiert wurden.

Ein Beispiel aus dem Alltag

Schauen wir uns ein einfaches Beispiel an: die Ampel. Sie wurde erstmals 1914 in den USA eingeführt und bis 1930 waren alle größeren amerikanischen Städte mit ihnen ausgestattet. In der Folgezeit wurden an den meisten Ampeln keine nennenswerten Änderungen oder Aktualisierungen vorgenommen, da mehr als die Hälfte der Ampelanlagen in den USA immer noch mit festen Zeitschaltuhren für jede Ampel arbeitet – ohne Sensoren oder Kameras, die die Dauer an den Verkehrsfluss anpassen können.

Ein innovativer Ansatz

Ein aktueller Vorschlag eines Teams der North Carolina State University unter der Leitung von Associate Engineering Professor Ali Hajbabaie geht von der Annahme aus, dass wir in einer Ära des autonomen Fahrens und eines Netzes miteinander verbundener Fahrzeuge (die mindestens 40 % des bestehenden Fuhrparks ausmachen) leben werden.

Dies eröffnet neue Möglichkeiten zur Aktualisierung und Anpassung unserer derzeitigen Infrastruktur, um den sicheren Einsatz dieser autonomen Fahrzeuge zu erleichtern. Die vorgeschlagene Lösung ist die Einführung einer „weißen Phase“ – eine mögliche vierte Ampel im Ampelsystem. Ihre Hauptfunktion besteht darin, autonomen Fahrzeugen zu signalisieren, dass es sicher ist, den Bewegungen des vorausfahrenden Fahrzeugs zu folgen. Dieser innovative Ansatz könnte die Effizienz und Sicherheit unserer künftigen Verkehrssysteme erheblich verbessern.

Ein Ausblick in die Zukunft

Eine letzte Frage an die KI zum Abschluss: Welche Trends der Automobilsoftware werden im Jahr 2044, also 20 Jahre später, eine Rolle spielen?

- Vollständig autonome Fahrzeuge: Im Jahr 2044 könnten autonome Fahrzeuge der Stufe 5, die unter allen Bedingungen ohne menschliches Eingreifen fahren können, weit verbreitet sein. Die Software für diese Fahrzeuge wäre unglaublich komplex und in der Lage, in Sekundenbruchteilen Entscheidungen für sicheres Fahren zu treffen.

- Vehicle-to-Everything (V2X)-Kommunikation: Autos werden nicht nur untereinander kommunizieren (V2V), sondern auch mit der Infrastruktur (V2I), Fußgängern (V2P) und Netzwerken (V2N). Dies ermöglicht ein effizienteres Verkehrsmanagement, mehr Sicherheit und ein angenehmeres Fahrerlebnis.

- KI und Maschinelles Lernen: Fortgeschrittene KI und Algorithmen des Maschinellen Lernens werden in der Automobilsoftware alltäglich sein und es den Fahrzeugen ermöglichen, aus ihren Erfahrungen zu lernen, potenzielle Gefahren vorherzusagen und sogar das Fahrerlebnis für jeden Benutzer zu personalisieren.

- Cybersecurity: Mit der zunehmenden Vernetzung von Fahrzeugen wird auch die Bedeutung der Cybersicherheit im Automobilbereich zunehmen. Es sind ausgeklügelte Softwarelösungen zu erwarten, die Fahrzeuge vor Hackerangriffen schützen und die Privatsphäre und Sicherheit der Fahrgäste gewährleisten.

- Software-Over-the-Air (SOTA)-Updates: Die Möglichkeit, Fahrzeugsoftware drahtlos zu aktualisieren, wird zum Standard werden und Echtzeit-Updates, Fehlerbehebungen und sogar die Einführung neuer Funktionen ermöglichen, ohne dass ein Servicetermin erforderlich ist.

- Integration mit Smart Cities: Automobilsoftware wird wahrscheinlich in die Infrastruktur von Smart Cities integriert werden und einen Beitrag zum Verkehrsmanagement, zur Energieeffizienz und zur Stadtplanung leisten.

- Grüne und energieeffiziente Software: Da das Streben nach Nachhaltigkeit anhält, ist zu erwarten, dass Software speziell für Elektro- und Hybridfahrzeuge entwickelt wird, die sich auf Energiemanagement, Effizienz und die Reduzierung der Umweltbelastung konzentriert.

- Digitale Zwillinge: Die Verwendung digitaler Zwillinge, also virtueller Nachbildungen physischer Fahrzeuge, wird sich immer mehr durchsetzen. Diese digitalen Zwillinge können für Tests, Simulationen und Optimierungen in einer risikofreien virtuellen Umgebung verwendet werden.

- Erweiterte Realität (AR) und virtuelle Realität (VR): AR könnte verwendet werden, um Fahrern verbesserte Informationen über ihre Umgebung zu liefern, während VR für Schulungs- und Simulationszwecke eingesetzt werden könnte.

Fazit

Die Antworten verdeutlichen, dass Daten weiterhin ein zentraler Faktor für die Entwicklung des Automobilsektors sind. Autonomes Fahren wird immer zugänglicher und die Sicherheitsbedingungen werden für alle Verkehrsteilnehmer verbessert. Dieser Fortschritt erfordert allerdings erhebliche Änderungen an unserer bestehenden Straßeninfrastruktur, den Vorschriften und dem Verkehrsrecht.