Your AI.

Trustworthy,

certification-ready

and future-proof.

Euer Partner für vertrauenswürdige und zertifizierbare KI.

Ein von uns entwickeltes medizinisches Machine-Learning System wurde mit dem TrustifAI Zertifikat des TÜV Austria ausgezeichnet.

Wir sind ISO 9001 zertifiziert.

Vertrauen ist der Schlüssel zum Erfolg mit KI

KI-Systeme treffen Entscheidungen. Selbst wenn ein Mensch in die Entscheidung einbezogen wird (human in the loop), ist Vertrauen in KI-Vorschläge Voraussetzung für Akzeptanz und return on investment. Dies gilt um so mehr, wenn KI in geschäftskritischen Bereichen wie Finanzen, Logistik oder Entwicklung eingesetzt wird und insbesondere in sicherheitskritischen Anwendungsfeldern wie Medizintechnik oder Fahrerassistenz.

„Da digitale Technologie ein immer zentralerer Bestandteil aller Aspekte des Lebens wird, sollten die Menschen in der Lage sein, ihr zu vertrauen. […] Dies ist eine Chance für Europa […] mit seiner erwiesenen Fähigkeit, sichere, zuverlässige und hochentwickelte Produkte und Dienstleistungen zu entwickeln, von der Luftfahrt über den Energiesektor bis zur Autoindustrie und Medizintechnik..“ [Aus dem Whitepaper der EU Komission]

Der AI Act der Europäischen Union wird in zahlreichen Hochrisikobereichen wie Infrastruktur, Personalwesen, Finanzdienstleistungen, Bildung und weiteren den Einsatz von KI reglementieren. KI wird nicht verboten, aber es wird Prüfpflichten geben, um Sicherheit, Robustheit und Fairness der KI-Systeme nachzuweisen. Wer Künstliche Intelligenz in einem Hochrisikobereich anwendet, bereitet sich bestenfalls schon heute auf die künftige Regulierung vor. Investment in vertrauenswürdige KI zahlt sich aus!

Wie funktioniert vertrauenswürdige KI?

Wie entwickeln wir mit einer so jungen Technologie wie Künstliche Intelligenz vertrauenswürdige Lösungen? Aus unserer Sicht gibt es drei entscheidende Faktoren:

Transparenz

Entscheidungen, die ein KI-System trifft, müssen transparent sein – vor allem hinsichtlich der Performance-Metriken und Daten, mit denen das System trainiert wurde.

Systematischer Entwicklungsprozess

Ein vertrauenswürdiges System lässt sich nur mit einem systematischen Prozess entwickeln, der auf bewährten best practices beruht.

Zertifizierung

Das stärkste Vertrauenssiegel ist die Zertifizierung des Systems durch eine renommierte und unabhängige Prüfstelle.

Kenne deine KI!

In einem gemeinsamen Workshop betrachten wir die individuellen KI-Anwendungsfälle mit ihren Herausforderungen und Potentialen. Durch Interviews und Analysen bewerten wir, wo ihr in Bezug auf vertrauenswürdige KI steht, basierend auf etablierten Kriterien, die auch von unabhängige Zertifizierungsstellen verwenden. Anschließend teilen wir mit euch eine detaillierte Analyse und geben pragmatische Empfehlungen, wie eventuelle Lücken geschlossen werden können.

Zertifiikat für künstliche Intelligenz

Wenn ihr das ultimative Vertrauenssiegel für eure KI anstrebt, begleiten wir euch durch diesen komplexen Prozess. Wir haben sowohl intern als auch mit Kunden bereits KI-Anwendungen entwickelt, die von einer unabhängigen Zertifizierungsstelle zertifiziert wurden – zum Beispiel eine medizinische Bilderkennung, die mit dem TrustifAI Zertifikat des TÜV Austria ausgezeichnet wurde. Auf der Grundlage dieser Erfahrung können wir euch reibungslos und effizient zur Zertifizierung leiten.

Wir unterstützen

Wir sind Expert:innen für data science, machine learning und KI, aber auch für ML- , data und cloud- engineering. Unsere Entwickler:innen, Architekt:innenen und Data Scientists packen an, wenn Zeitdruck besteht oder Unterstützung beim Schließen von Lücken benötigt wird.

So arbeiten wir

Unsere multidisziplinären Teams bestehen aus Product Ownern, Data Architects, Business- and Legal Consultants, sowie Data Scientists, Analysts, Ingenieur:innen und Data-Ops-Specialists, je nach Projektbedarf. Wir sind auf sechs Studios in Berlin, Hamburg, Stuttgart, München, Lissabon und Bukarest verteilt.

Einen tieferen Einblick in unseren Prozess zu vertrauenswürder KI bietet unser AI Principal David in folgendem Video:

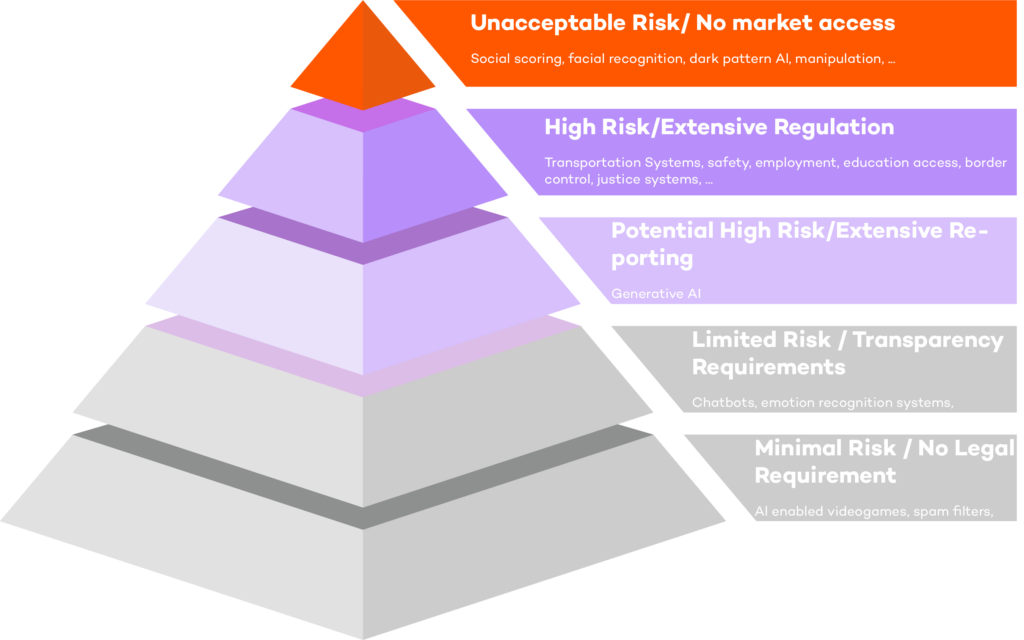

Der EU AI Act: Ein risikobasierter Ansatz

Die Europäische Union arbeitet mit dem AI-Act an der Regulierung von künstlicher Intelligenz. Es wird erwartet, dass das Gesetz spätestens Anfang 2025 in Kraft tritt. Der AI Act soll die Sicherheit von KI gewährleisten, insbesondere in risikoreichen Anwendungsbereichen, aber auch in Produkten und Dienstleistungen für Endverbraucher, die auf KI basieren. Außerdem sollen Diskriminierung durch voreingenommene automatisierte Entscheidungen und Desinformation (fake news) verhindert werden.

Der AI Act verfolgt einen abgestuften Ansatz bei der Regulierung, der insbesondere für KI-Systeme mit hohem Risiko strenge Standards vorsieht. Er kategorisiert KI-Systeme in fünf Gruppen: solche mit inakzeptablen Risiken, die verboten werden; Systeme mit hohem Risiko, die einer umfassenden Regulierung unterliegen; Systeme mit einem potenziell hohen Risiko wie z.B. Allzweck-KI-Systeme (sogenannte „General Purpose AI“, kurz GPAI), die in Zukunft grundlegenden Sicherheits- und Transparenzanforderungen unterliegen; Systeme mit begrenztem Risiko, die überwacht, aber nicht reguliert werden; und KI-Systeme mit minimalem Risiko, die keiner regulatorischen Aufsicht bedürfen.

Fällt mein KI-System in die Hochrisiko-Kategorie?

Wir lieben Daten und reden darüber

Unser applydata-Blog ist die Plattform, auf der unsere Expert:innen ihre Sicht auf die neuesten Entwicklungen in den Bereichen Daten, KI, Regulierung sowie Business- und Service-Design veröffentlichen.

Wir sprechen auch auf Konferenzen und veranstalten die applydata summit.

Wir sind Mitglied im KI-Bundesverband.

Wir sind Mitglied im Bitkom e.V., der mehr als 2.200 Unternehmen der digitalen Wirtschaft vertritt.

Legen wir los!

Sprechen wir über eure KI-Anwendung, regulatorische Anforderungen und vertrauenswürdige KI! Vertrauenswürdige KI ist ein Wettbewerbsvorteil, auch in unregulierten Anwendungsbereichen. Gemeinsam erarbeiten wir, wie eure KI volles Vertrauen bei Kunden und Stakeholdern gewinnt.